Der Zweck des H.264/AVC-Projekts besteht darin, einen Standard zu erstellen, der eine gute Videoqualität bei einer viel niedrigeren Bitrate als frühere Standards bietet (dh die halbe Bitrate von MPEG-2, H.263 oder MPEG- oder Mehr). niedrig). 4 Teil 2), ohne die Komplexität des Designs zu erhöhen, so dass es unpraktisch oder zu teuer in der Umsetzung ist. Ein weiteres Ziel besteht darin, genügend Flexibilität zu bieten, damit der Standard auf verschiedene Anwendungen in verschiedenen Netzwerken und Systemen angewendet werden kann, einschließlich niedriger und hoher Bitraten, niedrig- und hochauflösender Videos, Rundfunk, DVD-Speicher, RTP/IP-Paketnetzwerk und ITU-T Multimedia-Telefonanlage. Der H.264-Standard kann als "Standardfamilie" angesehen werden, die aus vielen verschiedenen Konfigurationsdateien besteht. Ein bestimmter Decoder decodiert mindestens eines, aber nicht unbedingt alle Profile. Die Decoderspezifikation beschreibt, welche Konfigurationsdateien decodiert werden können. H.264 wird normalerweise für verlustbehaftete Komprimierung verwendet, obwohl es auch möglich ist, wirklich verlustfreie Codierungsbereiche in verlustbehafteten codierten Bildern zu erstellen oder seltene Anwendungsfälle zu unterstützen, in denen die gesamte Codierung verlustfrei ist.

H.264 wurde von der ITU-T Video Coding Expert Group (VCEG) zusammen mit der ISO/IEC JTC1 Moving Picture Experts Group (MPEG) entwickelt. Die Projektpartnerschaft heißt Joint Video Team (JVT). Der ITU-T H.264-Standard und der ISO/IEC MPEG-4 AVC-Standard (ehemals ISO/IEC 14496-10-MPEG-4 Part 10, Advanced Video Coding) werden gemeinsam gepflegt, damit sie den gleichen technischen Inhalt haben. Die endgültige Ausarbeitung der ersten Ausgabe der Norm wurde im Mai 2003 abgeschlossen und die nachfolgenden Ausgaben wurden um verschiedene Funktionserweiterungen ergänzt. High Efficiency Video Coding (HEVC), nämlich H.265 und MPEG-H Teil 2, sind die Nachfolger von H.264/MPEG-4 AVC, die von derselben Organisation entwickelt wurden, und die früheren Standards werden immer noch häufig verwendet.

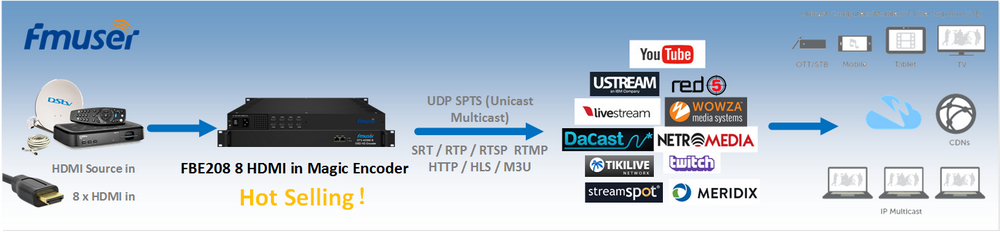

Der bekannteste H.264 ist wahrscheinlich einer der Videocodierungsstandards für Blu-ray-Discs; alle Blu-ray-Disc-Player müssen H.264 decodieren können. Es wird auch häufig beim Streamen von Internetressourcen wie Videos von Vimeo, YouTube und iTunes Store, Netzwerksoftware wie Adobe Flash Player und Microsoft Silverlight und verschiedenen HDTV-Sendungen vor Ort (ATSC, ISDB-T, DVB) verwendet oder DVB-T2), Kabel (DVB-C) und Satellit (DVB-S und DVB-S2).

H.264 ist durch Patente aller Parteien geschützt. Lizenzen, die die meisten (aber nicht alle) für H.264 erforderlichen Patente abdecken, werden vom Patentpool MPEG LA verwaltet. 3 Die kommerzielle Nutzung der patentierten H.264-Technologie erfordert die Zahlung von Lizenzgebühren an MPEG LA und andere Patentinhaber. MPEG LA ermöglicht die kostenlose Nutzung der H.264-Technologie, um Endbenutzern kostenloses Streaming von Internetvideos zur Verfügung zu stellen, und Cisco Systems zahlt im Namen seiner Open-Source-H.264-Encoder-Binärdateibenutzer an MPEG LA Lizenzgebühren.

1. Benennung

Der H.264-Name folgt der ITU-T-Namenskonvention, die ein Mitglied der H.26x-Serie von VCEG-Videocodierungsstandards ist; der Name MPEG-4 AVC bezieht sich auf die Namenskonvention in ISO/IEC MPEG, wobei der Standard ISO/IEC 14496 Teil 10 ist, ISO/IEC 14496 ist eine Reihe von Standards namens MPEG-4. Der Standard wurde gemeinsam in einer Partnerschaft zwischen VCEG und MPEG entwickelt, und zuvor wurde in ITU-T ein VCEG-Projekt namens H.26L durchgeführt. Daher werden häufig Namen wie H.264/AVC, AVC/H.264, H.264/MPEG-4AVC oder MPEG-4/H.264 AVC verwendet, um auf den Standard zu verweisen, um das gemeinsame Erbe hervorzuheben. Manchmal wird es auch "JVT-Codec" genannt, beziehen Sie sich auf die Organisation Joint Video Team (JVT), die es entwickelt hat. (Diese Art von Partnerschaft und Mehrfachbenennung sind keine Seltenheit. Zum Beispiel entstand der Videokomprimierungsstandard namens MPEG-2 auch aus der Partnerschaft zwischen MPEG und ITU-T, wobei MPEG-2-Video von der ITU-T-Gemeinschaft H. 262) Einige Softwareprogramme (wie der VLC Media Player) identifizieren diesen Standard intern als AVC4.

2. Geschichte

Anfang 1998 veröffentlichte die Video Coding Expert Group (VCEG-ITU-T SG16 Q.6) eine Aufforderung zur Einreichung von Vorschlägen für ein Projekt namens H.26L, mit dem Ziel, die Codierungseffizienz zu verdoppeln (was bedeutet, dass die erforderliche Bitrate halbiert) Ein gegebenes Maß an Wiedergabetreue im Vergleich zu anderen existierenden Videocodierungsstandards, die für verschiedene Anwendungen verwendet werden. Vorsitzender der VCEG ist Gary Sullivan (Microsoft, ehemals PictureTel, USA). Der erste Entwurf der neuen Norm wurde im August 1999 verabschiedet. Im Jahr 2000 wurde Thomas Wiegand (Heinrich-Hertz-Institut, Deutschland) Co-Vorsitzender des VCEG.

Im Dezember 2001 bildeten VCEG und die Moving Picture Experts Group (MPEG-ISO / IEC JTC 1 / SC 29 / WG 11) eine Joint Video Group (JVT), deren Charta den Videocodierungsstandard finalisierte. [5] Die Spezifikation wurde im März 2003 offiziell genehmigt. JVT wurde von Gary Sullivan, Thomas Wiegand und Ajay Luthra (Motorola, USA: später Arris, USA) geleitet. Im Juni 2004 wurde das Projekt Fidelity Scope Extension (FRExt) abgeschlossen. Von Januar 2005 bis November 2007 arbeitet JVT an der Erweiterung von H.264/AVC auf Skalierbarkeit durch einen Anhang (G) namens Scalable Video Coding (SVC). Das Führungsteam der JVT wurde um Jens-Rainer Ohm (Universität Aachen, Deutschland) erweitert. Von Juli 2006 bis November 2009 führte JVT Multi-Video Video Coding (MVC) ein, eine Erweiterung von H.264/AVC auf Free-View-TV und 3D-TV. Diese Arbeit beinhaltet die Entwicklung von zwei neuen Standardprofilen: Multiview High Profile und Stereo High Profile.

Die Standardisierung der ersten Version von H.264/AVC wurde im Mai 2003 abgeschlossen. Im ersten Projekt zur Erweiterung des ursprünglichen Standards entwickelte JVT anschließend die sogenannten Fidelity Range Extensions (FRExt). Diese Erweiterungen erreichen eine qualitativ hochwertigere Videocodierung, indem sie eine höhere Abtastbittiefengenauigkeit und höher aufgelöste Farbinformationen unterstützen, einschließlich des sogenannten Y'CbCr 4:2:2 (= YUV 4:2:2) und Y'CbCr 4:4 Sampling Struktur: 4. Das Fidelity Range Extensions-Projekt umfasst auch andere Funktionen, wie das adaptive Umschalten zwischen 4×4 und 8×8 Integer-Transformationen, wahrnehmungsbasierte Quantisierungsgewichtungsmatrizen, die vom Encoder spezifiziert werden, effiziente verlustfreie Codierung zwischen Bildern und Unterstützung für zusätzliche Farbräume . Die Entwurfsarbeiten von Fidelity Range Extensions wurden im Juli 2004 abgeschlossen und die Entwurfsarbeiten wurden im September 2004 abgeschlossen.

Die jüngste weitere Erweiterung des Standards umfasst das Hinzufügen von fünf weiteren neuen Profilen [welches? ] Hauptsächlich für professionelle Anwendungen verwendet, um erweiterte Farbraumunterstützung hinzuzufügen, zusätzliche Anzeigen für das Seitenverhältnis zu definieren, zwei andere Arten von "ergänzenden Verbesserungsinformationen" (Nachfilterhinweise und Tonwertzuordnung) zu definieren und die vorherige FRExt-Konfigurationsdatei zu verwerfen Eins (hoch 4:4:4-Profil), Branchenfeedback [von wem? ] Die Anleitung sollte anders gestaltet sein.

Das nächste wichtige Feature, das dem Standard hinzugefügt wurde, ist Scalable Video Coding (SVC). In Anhang G von H.264/AVC ist festgelegt, dass SVC die Konstruktion von Bitströmen ermöglicht, die ebenfalls dem Standard entsprechende Teilbitströme enthalten, einschließlich eines solchen Bitstroms namens "Basisschicht", der von H.264/ dekodiert werden kann. AVC-Codec, der SVC unterstützt. Für eine zeitliche Skalierbarkeit des Bitstroms (dh es gibt Unterbitströme mit einer kleineren zeitlichen Abtastrate als der Hauptbitstrom) werden vollständige Zugriffseinheiten aus dem Bitstrom entfernt, wenn der Unterbitstrom abgeleitet wird. In diesem Fall werden die High-Level-Syntax und die Interprädiktions-Referenzbilder im Bitstrom entsprechend konstruiert. Auf der anderen Seite entferne für eine räumliche und qualitative Skalierbarkeit des Bitstroms (dh es gibt Unterbitströme mit geringerer räumlicher Auflösung/Qualität als der Hauptbitstrom) NAL aus dem Bitstrom, wenn der Unterbitstrom abgeleitet wird (Netzwerkabstraktionsschicht). . In diesem Fall wird die Zwischenschicht-Vorhersage (dh Vorhersage eines Signals mit höherer räumlicher Auflösung/Qualität aus Daten eines Signals mit niedrigerer räumlicher Auflösung/Qualität) im Allgemeinen für eine effiziente Codierung verwendet. Die skalierbare Videocodierungserweiterung wurde im November 2007 abgeschlossen.

Die nächste wichtige Funktion, die dem Standard hinzugefügt wurde, ist Multi-View Video Coding (MVC). In Anhang H von H.264/AVC ist festgelegt, dass MVC die Konstruktion eines Bitstroms ermöglicht, der mehr als eine Ansicht einer Videoszene darstellt. Ein wichtiges Beispiel für diese Funktion ist die stereoskopische 3D-Videokodierung. In der MVC-Arbeit wurden zwei Profile entwickelt: Multiview High Profile unterstützt eine beliebige Anzahl von Ansichten und Stereo High Profile wurde speziell für Stereovideo mit zwei Ansichten entwickelt. Die Multiview-Videocodierungserweiterung wurde im November 2009 fertiggestellt.

3. Anwendung

Das H.264-Videoformat hat ein sehr breites Anwendungsspektrum, das alle Formen von digital komprimiertem Video abdeckt, von Internet-Streaming-Anwendungen mit niedriger Bitrate über HDTV-Übertragungen bis hin zu nahezu verlustfreien Codierungs-Digitalfilmanwendungen. Durch die Verwendung von H.264 kann die Bitrate im Vergleich zu MPEG-2 Teil 2 um 50 % oder mehr eingespart werden. Es wird beispielsweise berichtet, dass die Qualität des digitalen Satellitenfernsehens von H.264 mit der aktuellen Implementierung von MPEG-2 mit einer Bitrate von weniger als der Hälfte identisch ist. Die aktuelle Implementierungsrate von MPEG-2 beträgt etwa 3.5 Mbit/s, während H.264 nur 1.5 Mbit beträgt. /s. [23] Sony behauptet, dass der 9-Mbit/s-AVC-Aufnahmemodus der Bildqualität des HDV-Formats entspricht, das etwa 18-25 Mbit/s verwendet.

Um H.264/AVC-Kompatibilität und problemlose Übernahme zu gewährleisten, haben viele Normungsorganisationen ihre videobezogenen Standards geändert oder ergänzt, sodass Benutzer dieser Standards H.264/AVC verwenden können. Sowohl das Blu-ray Disc-Format als auch das inzwischen eingestellte HD-DVD-Format verwenden H.264 / AVC High Profile als eines der drei obligatorischen Videokomprimierungsformate. Das Digital Video Broadcasting Project (DVB) genehmigte Ende 264 die Verwendung von H.2004/AVC für das Rundfunkfernsehen.

Das Standardisierungsgremium des American Advanced Television System Committee (ATSC) genehmigte H.264/AVC im Juli 2008 für Rundfunkfernsehen, obwohl der Standard noch nicht für feste ATSC-Sendungen in den Vereinigten Staaten verwendet wurde. [25] [26] Es ist auch für den neuesten ATSC-M/H (Mobile/Handheld)-Standard unter Verwendung der AVC- und SVC-Teile von H.264 zugelassen.

Die Märkte CCTV (Closed Circuit Television) und Videoüberwachung haben diese Technologie in viele Produkte integriert. Viele gängige DSLR-Kameras verwenden H.264-Video, das im QuickTime MOV-Container enthalten ist, als natives Aufnahmeformat.

4. Abgeleitetes Format

AVCHD ist ein hochauflösendes Aufnahmeformat, das von Sony und Panasonic entwickelt wurde und H.264 verwendet (kompatibel mit H.264, während andere anwendungsspezifische Funktionen und Einschränkungen hinzugefügt werden).

AVC-Intra ist ein von Panasonic entwickeltes Intra-Frame-Kompressionsformat.

XAVC ist ein von Sony entwickeltes Aufnahmeformat und verwendet Level 5.2 von H.264/MPEG-4 AVC, das ist das höchste Level, das von diesem Videostandard unterstützt wird. [28] [29] XAVC unterstützt 4K-Auflösungen (4096 × 2160 und 3840 × 2160) mit Geschwindigkeiten von bis zu 60 Bildern pro Sekunde (fps). [28] [29] Sony gab bekannt, dass XAVC-fähige Kameras zwei CineAlta-Kameras umfassen – Sony PMW-F55 und Sony PMW-F5. [30] Sony PMW-F55 kann XAVC aufnehmen, 4K-Auflösung beträgt 30 fps, Geschwindigkeit 300 Mbit/s, 2K-Auflösung, 30 fps, 100 Mbit/s. [31] XAVC kann eine 4K-Auflösung mit 60 fps aufzeichnen und ein 4:2:2-Chroma-Subsampling mit 600 Mbit/s durchführen.

5. Eigenschaften

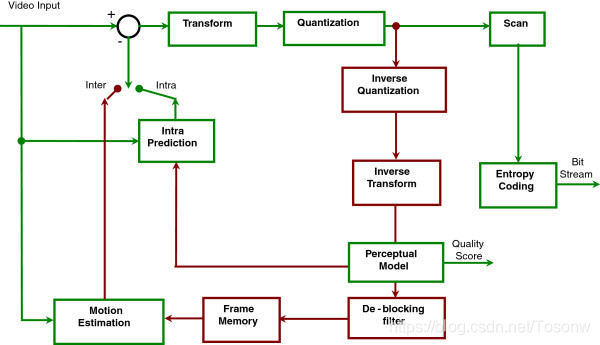

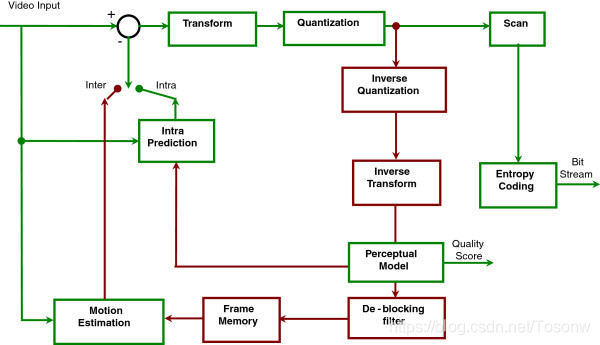

Blockschaltbild von H.264

H.264 / AVC / MPEG-4 Part 10 enthält viele neue Funktionen, die eine effizientere Videokomprimierung als der alte Standard ermöglichen und eine größere Flexibilität für Anwendungen in verschiedenen Netzwerkumgebungen bieten. Einige dieser Schlüsselfunktionen umfassen insbesondere:

1) Die Mehrbild-Zwischenbild-Vorhersage umfasst die folgenden Funktionen:

Verwenden Sie zuvor kodierte Bilder flexibler als frühere Standards als Referenzen, sodass in einigen Fällen bis zu 16 Referenzbilder (oder 32 Referenzfelder bei Zeilensprungkodierung) verwendet werden können. In Profilen, die Nicht-IDR-Frames unterstützen, geben die meisten Ebenen an, dass genügend Pufferung vorhanden sein sollte, um mindestens 4 oder 5 Referenzframes bei maximaler Auflösung zuzulassen. Dies steht im Gegensatz zu bestehenden Standards, die normalerweise eine Grenze von 1 haben; oder im Fall von traditionellen "B-Bildern" (B-Frames) zwei. Diese spezielle Funktion ermöglicht in den meisten Szenarien normalerweise eine bescheidene Verbesserung der Bitrate und Qualität. [Zitat erforderlich] Bei bestimmten Arten von Szenen, wie Szenen mit sich wiederholenden Aktionen oder dem Hin- und Herschalten von Szenen oder unbedeckten Hintergrundbereichen, kann die Bitrate jedoch erheblich reduziert werden, während die Klarheit erhalten bleibt.

Bewegungskompensation mit variabler Blockgröße (VBSMC), die Blockgröße beträgt 16 × 16, so klein wie 4 × 4, wodurch die präzise Segmentierung des Bewegungsbereichs realisiert werden kann. Die unterstützten Luma-Vorhersage-Blockgrößen umfassen 16×16, 16×8, 8×16, 8×8, 8×4, 4×8 und 4×4, von denen viele zusammen in einem einzigen Makroblock verwendet werden können. Entsprechend der verwendeten Chrominanz-Unterabtastung ist die Chrominanzprädiktionsblockgröße entsprechend kleiner.

Im Fall eines B-Makroblocks, der aus 16 4×4-Partitionen besteht, kann jeder Makroblock mehrere Bewegungsvektoren (einen oder zwei für jede Partition) mit maximal 32 verwenden. Der Bewegungsvektor jedes 8×8- oder größeren Partitionsbereichs kann zeigen zu einem anderen Referenzbild.

Jeder Makroblocktyp kann in B-Frames verwendet werden, einschließlich I-Makroblöcken, was zu einer effizienteren Codierung bei Verwendung von B-Frames führt. Diese Eigenschaft kann man am MPEG-4 ASP erkennen.

Sechs-Tap-Filterung, die verwendet wird, um eine Halbpixel-Luminanzabtastvorhersage für eine klarere Subpixel-Bewegungskompensation abzuleiten. Die Viertelpixel-Bewegung wird durch lineare Interpolation von Halbfarbwerten abgeleitet, um Rechenleistung zu sparen.

Die für die Bewegungskompensation verwendete Viertelpixel-Präzision kann die Verschiebung des Bewegungsbereichs genau beschreiben. Bei Chroma wird die Auflösung normalerweise in vertikaler und horizontaler Richtung halbiert (siehe 4:2:0), daher verwendet die Bewegungskompensation von Chroma eine Achtel-Chroma-Pixel-Rastereinheit.

Die gewichtete Vorhersage ermöglicht es dem Encoder, die Verwendung von Skalierung und Offset bei der Durchführung der Bewegungskompensation festzulegen, und bietet erhebliche Leistungsvorteile in speziellen Situationen – wie Ein- und Ausblenden, Ein- und Einblenden und Ein- und Ausblenden von Übergängen. Dies umfasst die implizite gewichtete Vorhersage von B-Frames und die explizite gewichtete Vorhersage von P-Frames.

Räumliche Vorhersage für die Kanten benachbarter Blöcke für die "Intra"-Kodierung anstelle der "DC"-Vorhersage in MPEG-2 Teil 2 und der Transformationskoeffizienten-Vorhersage in H.263v2 und MPEG-4 Teil 2:

Dies umfasst Luma-Vorhersageblockgrößen von 16 × 16, 8 × 8 und 4 × 4 (wobei in jedem Makroblock nur ein Typ verwendet werden kann).

2) Zu den verlustfreien Makroblock-Codierungsfunktionen gehören:

Der verlustfreie "PCM-Makroblock" stellt den Modus dar, der die Videodatenabtastwerte direkt repräsentiert, [34] ermöglicht die perfekte Darstellung eines bestimmten Bereichs und erlaubt strenge Beschränkungen der Menge der codierten Daten für jeden Makroblock.

Der verbesserte verlustfreie Makroblock-Darstellungsmodus ermöglicht eine perfekte Darstellung eines bestimmten Bereichs, während er im Allgemeinen viel weniger Bits verwendet als der PCM-Modus.

Flexible Interlaced-Videokodierungsfunktionen, einschließlich:

Makroblockadaptive Frame-Field-Codierung (MBAFF) verwendet eine Makroblock-Paarstruktur für das als Frame codierte Bild, was 16×16 Makroblöcke im Halbbildmodus ermöglicht (im Vergleich zu MPEG-2, wo die Halbbildmodus-Verarbeitung im Bild implementiert ist ergibt die Verarbeitung von 16×8 Semi-Makroblöcken).

Die bildadaptive Frame- und Field-Codierung (PAFF oder PicAFF) ermöglicht das Mischen und Codieren frei wählbarer Bilder als komplettes Frame, bei dem zwei Felder zur Codierung kombiniert werden, oder als einzelnes Einzelfeld.

Neue Konvertierungsdesignfunktionen, einschließlich:

Exakt übereinstimmende ganzzahlige 4×4 räumliche Blocktransformation, die eine genaue Platzierung von Restsignalen ermöglicht, fast kein "Klingeln", das bei früheren Codec-Designs üblich war. Dieses Design ähnelt im Konzept der wohlbekannten diskreten Kosinustransformation (DCT), die 1974 von N. Ahmed, T. Natarajan und KR Rao eingeführt wurde, und ist eine Referenz 1 in der diskreten Kosinustransformation. Es ist jedoch vereinfacht und bietet eine genau spezifizierte Dekodierung.

Genaue Anpassung von ganzzahligen 8×8 räumlichen Blocktransformationen, was eine effizientere Kompression hochkorrelierter Regionen als 4×4 Transformationen ermöglicht. Das Design ähnelt im Konzept dem wohlbekannten DCT, ist jedoch vereinfacht und bereitgestellt, um eine genau spezifizierte Decodierung bereitzustellen.

Adaptive Encoderauswahl zwischen 4×4 und 8×8 Transformationsblockgrößen für ganzzahlige Transformationsoperationen.

Eine sekundäre Hadamard-Transformation wird an den "DC"-Koeffizienten der Hauptraumtransformation durchgeführt, die auf die Chrominanz-DC-Koeffizienten (und in einem speziellen Fall auch die Luminanz) angewendet wird, um noch mehr Kompression im glatten Bereich zu erhalten.

3) Quantitatives Design beinhaltet:

Logarithmische Schrittweitensteuerung, einfacheres Bitratenmanagement und vereinfachte inverse Quantisierungsskalierung durch den Encoder

Die vom Encoder ausgewählte frequenzindividuelle Quantisierungsskalierungsmatrix wird zur wahrnehmungsbasierten Quantisierungsoptimierung verwendet

Der Loop-Deblocking-Filter hilft, den Blockeffekt zu verhindern, der bei anderen DCT-basierten Bildkomprimierungstechnologien üblich ist, um ein besseres visuelles Erscheinungsbild und eine bessere Komprimierungseffizienz zu erzielen

4) Das Design der Entropiecodierung umfasst:

Kontextadaptive binäre arithmetische Codierung (CABAC), ein Algorithmus zur verlustfreien Komprimierung von Syntaxelementen in einem Videostream, der die Wahrscheinlichkeit von Syntaxelementen in einem bestimmten Kontext kennt. CABAC komprimiert Daten effizienter als CAVLC, erfordert jedoch mehr Verarbeitung zum Decodieren.

Kontextadaptive variable Längencodierung (CAVLC), die eine Alternative zu CABAC mit geringerer Komplexität ist, die verwendet wird, um quantisierte Transformationskoeffizientenwerte zu codieren. Obwohl die Komplexität geringer ist als bei CABAC, ist CAVLC verfeinert und effektiver als Verfahren, die üblicherweise verwendet werden, um Koeffizienten in anderen existierenden Designs zu codieren.

Eine übliche einfache und hochstrukturierte Codierungstechnik mit variabler Länge (VLC), die für viele Syntaxelemente verwendet wird, die nicht von CABAC oder CAVLC codiert werden, wird als Exponential-Golomb-Codierung (oder Exp-Golomb) bezeichnet.

5) Die Funktionen zur Verlustrückgewinnung umfassen:

Die Definition der Netzwerkabstraktionsschicht (NAL) ermöglicht die Verwendung derselben Videosyntax in vielen Netzwerkumgebungen. Ein sehr grundlegendes Designkonzept von H.264 besteht darin, in sich geschlossene Datenpakete zu generieren, um doppelte Header zu entfernen, wie beispielsweise den Header Extension Code (HEC) von MPEG-4. Dies wird durch das Entkoppeln von Informationen, die sich auf mehrere Slices beziehen, aus dem Medienstrom erreicht. Die Kombination von erweiterten Parametern wird als Parametersatz bezeichnet. [35] Die H.264-Spezifikation umfasst zwei Arten von Parametersätzen: Sequence Parameter Set (SPS) und Picture Parameter Set (PPS). Der effektive Sequenzparametersatz bleibt in der gesamten codierten Videosequenz unverändert, und der effektive Bildparametersatz bleibt innerhalb des codierten Bildes unverändert. Die Sequenz- und Bildparametersatzstruktur enthält Informationen wie die Bildgröße, den gewählten optionalen Codierungsmodus und die Makroblock-zu-Slice-Gruppenzuordnung.

Flexible Macroblock Ordering (FMO), auch bekannt als Slice Group, und Arbitrary Slice Ordering (ASO) ist eine Technik, die verwendet wird, um die Reihenfolge der Darstellung von Basisbereichen (Makroblöcken) in einem Bild zu rekonstruieren. Im Allgemeinen als Fehler-/Verlustrobustheitsfunktionen angesehen, können FMO und ASO auch für andere Zwecke verwendet werden.

Data Partitioning (DP), eine Funktion, die die wichtigeren und weniger wichtigen Syntaxelemente in verschiedene Datenpakete aufteilen kann, kann Unequal Error Protection (UEP) und andere Arten von Verbesserungen der Fehler-/Verlust-Robustheit anwenden.

Redundant Slice (RS), eine Robustheitsfunktion für Fehler/Verluste, die es dem Encoder ermöglicht, eine zusätzliche Darstellung des Bildbereichs (normalerweise mit geringerer Genauigkeit) zu senden, die verwendet werden kann, wenn die Hauptdarstellung beschädigt ist oder verloren geht .

Bildnummer, die die Erstellung einer "Untersequenz"-Funktion ermöglicht, eine zeitliche Skalierbarkeit durch optionales Einfügen zusätzlicher Bilder zwischen andere Bilder ermöglicht und den Verlust des gesamten Bildes erkennt und ausblendet, der durch Netzwerkpaketverlust oder Kanal verursacht werden kann Ein Fehler ist aufgetreten.

Das Umschalten von Slices, SP- und SI-Slices genannt, ermöglicht es dem Codierer, den Decodierer anzuweisen, zum laufenden Videostrom zu springen, beispielsweise zum Umschalten der Videostrom-Bitrate und "Trickmodus"-Operationen. Wenn der Decoder die SP/SI-Funktion verwendet, um in die Mitte des Videostreams zu springen, kann er eine genaue Übereinstimmung mit dem decodierten Bild an dieser Position im Videostream erzielen, obwohl ein anderes Bild oder gar kein Bild verwendet wird, wie z vorherige Referenz. Schalter.

Ein einfacher automatischer Prozess, der verwendet wird, um eine versehentliche Simulation des Startcodes zu verhindern, bei dem es sich um eine spezielle Bitfolge in den codierten Daten handelt, ermöglicht einen wahlfreien Zugriff auf den Bitstrom und stellt die Byteausrichtung in Systemen wieder her, bei denen die Bytesynchronisation verloren gehen kann.

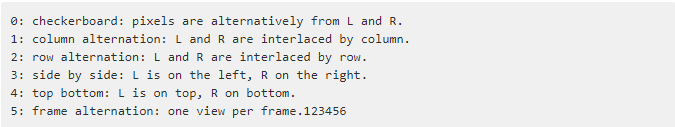

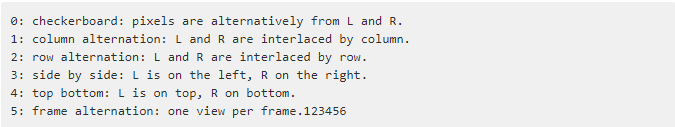

Supplemental Enhancement Information (SEI) und Video Usability Information (VUI) sind zusätzliche Informationen, die in den Bitstream eingefügt werden können, um das Video für verschiedene Zwecke zu verbessern. [Klarstellung erforderlich] SEI FPA (Frame Encapsulation Arrangement) enthält eine 3D-Anordnung von Nachrichten:

Hilfsbild, das für die Alpha-Synthese und andere Zwecke verwendet werden kann.

Unterstützt Monochrom (4:0:0), 4:2:0, 4:2:2 und 4:4:4 Chroma-Subsampling (je nach ausgewähltem Profil).

Unterstützt die Genauigkeit der Sampling-Bittiefe im Bereich von 8 bis 14 Bit pro Sample (je nach ausgewähltem Profil).

Kann jede Farbebene in verschiedene Bilder mit eigener Slice-Struktur, Makroblock-Modus, Bewegungsvektor usw. codieren, was die Verwendung einer einfachen parallelen Struktur zum Entwerfen des Codierers ermöglicht (nur drei Konfigurationsdateien, die 4:4:4 unterstützen, werden unterstützt ) .

Die Bildsequenzzählung wird verwendet, um die Reihenfolge der Bilder und die Eigenschaften der Abtastwerte im decodierten Bild isoliert von den Timing-Informationen beizubehalten, sodass das System die Timing-Informationen separat übertragen und steuern/ändern kann, ohne den Inhalt der dekodiertes Bild.

Diese Technologien und mehrere andere Technologien helfen H.264, in verschiedenen Anwendungsumgebungen in verschiedenen Situationen eine bessere Leistung als jeder frühere Standard zu erbringen. H.264 bietet im Allgemeinen eine bessere Leistung als MPEG-2-Video – normalerweise die gleiche Qualität bei der halben Bitrate oder niedriger, insbesondere bei hohen Bitraten und hohen Auflösungen.

Wie andere ISO/IEC MPEG-Videostandards verfügt auch H.264/AVC über eine Referenzsoftwareimplementierung, die kostenlos heruntergeladen werden kann. Sein Hauptzweck besteht darin, Beispiele für H.264/AVC-Funktionen bereitzustellen, keine nützliche Anwendung an sich. Die Motion Picture Experts Group führt auch einige Referenz-Hardware-Designarbeiten durch. Die oben genannten sind die vollständigen Funktionen von H.264/AVC, die alle Konfigurationsdateien von H.264 abdecken. Das Profil eines Codecs ist ein Satz von Merkmalen des Codecs, der identifiziert wird, um bestimmte Spezifikationen für die beabsichtigte Anwendung zu erfüllen. Dies bedeutet, dass einige Konfigurationsdateien viele der aufgeführten Funktionen nicht unterstützen. Die verschiedenen Konfigurationsdateien von H.264/AVC werden im nächsten Abschnitt besprochen.

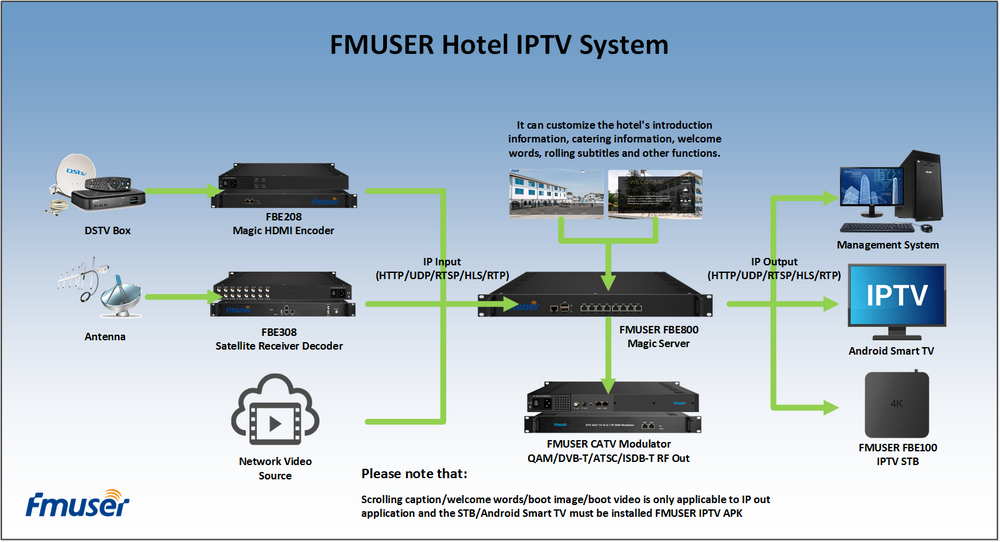

Unsere anderen Produkt: